Rapports sur les projets spéciaux sur les entreprises

Classification des types d’immeubles au moyen d’images prises à partir de la rue à l’aide de réseaux neuronaux convolutifs

Passer au texte

Début du texte

Remerciements

L’auteur du rapport tient à remercier Alessandro Alasia pour son précieux soutien, son aide et ses commentaires. L’auteur aimerait également remercier le Conseil de recherche et développement de Statistique Canada qui a financé le présent projet.

Information pour l’usager

Signes conventionnels

Les signes conventionnels suivants sont employés dans l’article :

- α Taux d’apprentissage.

- p Valeur du momentum.

- ꞷ Facteur de dégradation.

Résumé

Les microdonnées sur les bâtiments et les infrastructures physiques sont de plus en plus pertinentes pour les programmes statistiques dans les sphères sociale, économique et environnementale. De nouvelles sources de données et des méthodes d’analyse avancées peuvent être utilisées pour générer une partie de cette information. Le présent rapport explique comment les réseaux neuronaux convolutifs (RNC) multiples sont peaufinés aux fins de la classification des bâtiments en fonction de leurs différents types (p. ex. maisons, immeubles d’appartements, bâtiments industriels) au moyen d’images prises à partir de la rue. Les RNC utilisent la structure de la façade dans l’image du bâtiment aux fins de sa classification. Plusieurs RNC de pointe ont été peaufinés pour accomplir la tâche de classification. Les modèles entraînés fournissent une validation de principe et montrent que les RNC peuvent servir à classer les bâtiments au moyen de leurs images prises à partir de la rue. Le rendement obtenu aux phases d’entraînement et de validation des RNC entraînés a été mesuré. De plus, les RNC entraînés sont évalués au moyen d’un ensemble de données de test distinct d’images prises à partir de la rue. Cette approche peut être utilisée pour accroître les renseignements disponibles dans les bases de données de libre accès, comme la Base de données ouvertes sur les immeubles.

1 Introduction

Le type d’immeuble est un élément d’information important qui a des applications cruciales sur le plan de l’analyse sociale et économique de même que pour l’urbanisme. Il est important de disposer d’une base de données à jour à grande échelle qui renferme de tels renseignements au niveau local et national. Par exemple, l’élaboration d’une stratégie sur le logement exige des renseignements à jour sur les types d’immeubles existants et nouveaux. Les données sur les types d’immeubles et le développement immobilier, dans chaque secteur de compétence, peuvent aider les divers ordres de gouvernement à mettre en place des politiques visant à améliorer la qualité de vie et l’accès aux services dans chaque quartier, à surveiller l’offre de logements et à améliorer l’accès à des logements abordables.

Dans plusieurs secteurs de compétence, il est possible de se procurer les données sur les types d’immeubles auprès des sources administratives. Toutefois, ces données n’existent pas pour toutes les municipalités ou pour des secteurs particuliers d’une ville ou d’une municipalité. Même si de tels ensembles de données sont constitués, ils sont parfois difficilement accessibles ou inaccessibles dans des formats normalisés. La création ou la mise à jour d’une base de données sur les types d’immeubles pour une grande région urbaine peuvent se faire au moyen de relevés, mais ces approches traditionnelles peuvent demander beaucoup de travail et s’avérer coûteuses. L’extraction automatique à grande échelle de ces données à l’aide d’images prises à partir de la rue peut offrir une solution de rechange viable.

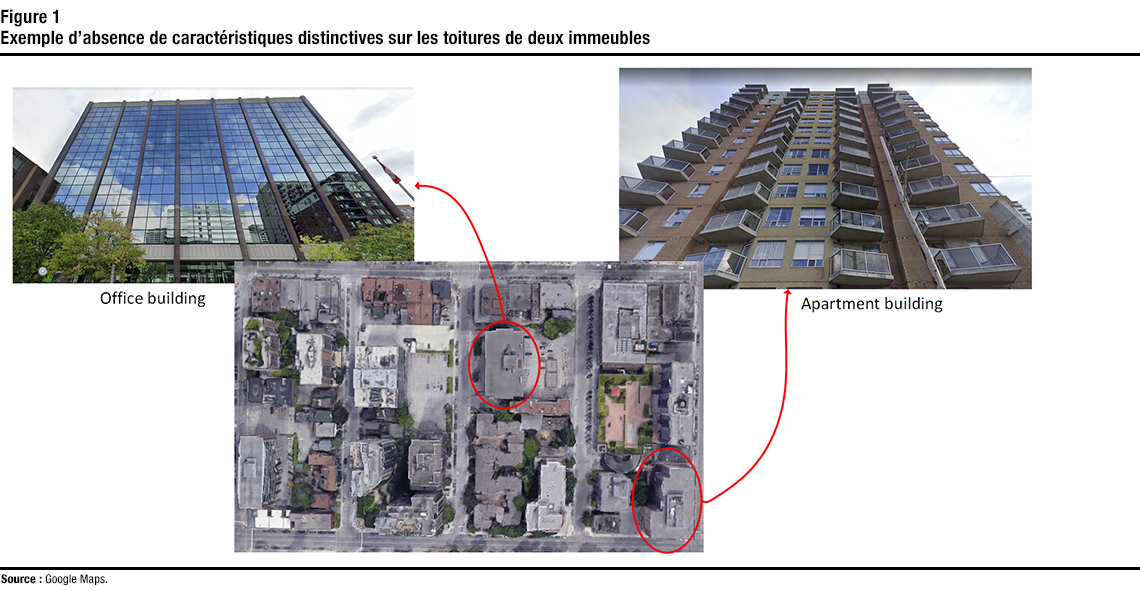

Description de la figure 1

Cette figure montre des images au niveau de la rue d’un immeuble de bureaux et d’un immeuble d’appartements, et une image aérienne du sommet des deux immeubles. La figure illustre comment les images au niveau de la rue peuvent montrer les caractéristiques distinctives de la façade des immeubles qui pourraient ne pas être visibles autrement à partir de la toitureDe nombreux travaux ont été réalisés dans le milieu universitaire et dans l’industrie afin d’extraire des données semblables sur les zones urbaines à l’aide de la télédétection. Par exemple, l’imagerie aérienne ou satellitaire a été utilisée pour recueillir des renseignements comme l’utilisation des terres en région urbaine et la couverture terrestre (Giri, 2016). Bien que les images aériennes et satellitaires puissent être utilisées pour extraire de telles données concernant une zone urbaine ou un quadrilatère, il demeure difficile de les utiliser pour classer les immeubles individuellement selon leur type. En effet, ces images ne fournissent pas une vue des façades des bâtiments, où les distinctions entre les différents types d’immeubles sont généralement apparentes. Comme le montre la figure 1, il n’existe pas de distinction explicite entre les toitures des différents types d’immeubles (p. ex. entre la toiture d’un immeuble d’appartements et celle d’un immeuble de bureaux), ce qui rend difficile l’utilisation de telles images pour établir le type d’immeuble.

Les images prises à partir de la rue offrent une vue rapprochée des façades de l’immeuble et peuvent donc être utilisées pour établir le type d’immeuble. On trouve dans la littérature des initiatives d’extraction de données à partir d’images prises à partir de la rue. Elles comprenaient différentes applications, dont l’estimation de l’utilisation des terres (Li et coll., 2017) et de la composition démographique de quartiers (Gebru et coll., 2017). De plus, les images prises à partir de la rue ont été utilisées aux fins de classification des instances de bâtiments (Kang et coll., 2018). Les résultats des travaux cités montrent que les images prises à partir de la rue peuvent effectivement constituer une riche source d’information dans de multiples applications.

Dans le présent rapport, les RNC multiples sont peaufinés aux fins de la classification des bâtiments selon différents types (p. ex. maisons, immeubles d’appartements, bâtiments industriels) au moyen d’images prises à partir de la rue. Les ensembles de données utilisés pour peaufiner les paramètres des RNC et les tester ont été constitués par (Kang et coll., 2018), et mis à la disposition du public. Les caractéristiques des structures de façade des bâtiments qui apparaissent dans les images de la rue peuvent être saisies par les RNC et utilisées à des fins de classification. L’ensemble de données d’entraînement a été examiné et nettoyé manuellement afin de réduire les erreurs introduites par l’étiquetage automatique. Par la suite, plusieurs RNC de pointe ont été peaufinés pour accomplir la tâche de classification en utilisant l’ensemble de données amélioré. Le rendement obtenu aux phases d’entraînement et de validation de chaque RNC entraîné a été mesuré. De plus, les RNC entraînés ont été évalués au moyen d’un ensemble de données de test distinct d’images prises à partir de la rue (également fourni par l’ensemble de données de référence) de villes différentes de celles de l’ensemble de données d’entraînement. Les résultats obtenus montrent que le nettoyage de l’ensemble de données et le réglage des hyperparamètres ont permis d’améliorer considérablement les résultats obtenus par (Kang et coll., 2018).

Le plan du rapport est le suivant : La section 2 donne un aperçu de l’apprentissage profond et de son utilisation dans la vision par ordinateur. La section 3 traite des ensembles de données et de l’entraînement des RNC utilisés dans la présente analyse. La section 4 présente les résultats obtenus, et la section 5 comporte la conclusion.

2 Apprentissage profond et réseaux neuronaux convolutifs

L’évolution constante des ressources de traitement comme les unités de traitement graphique et les ressources infonuagiques, ainsi que la disponibilité croissante de grands ensembles de données d’accès public pour l’analyse et l’élaboration de modèles ont accru la popularité de l’apprentissage automatique et de l’apprentissage profond pour saisir les structures complexes de données à grande échelle (Voulodimos et coll., 2018). L’apprentissage profond est actuellement un domaine très populaire qui a des applications dans de nombreux domaines tels que la vision par ordinateur et la vision industrielle, la reconnaissance automatique de la parole et le traitement automatique des langues.

La vision par ordinateur est un domaine où l’apprentissage profond est de plus en plus déployé pour extraire de l’information à partir de différents types d’images. La popularité croissante des approches basées sur l’apprentissage profond s’explique par le fait qu’elles donnent généralement de meilleurs résultats pour la vision par ordinateur que les techniques traditionnelles où les caractéristiques sont définies de façon explicite (Voulodimos et coll., 2018). Une catégorie particulière de réseaux neuronaux, les RNC, est de plus en plus populaire dans le domaine de la vision par ordinateur et est utilisée pour accomplir diverses tâches telles que la détection et la classification des objets, la segmentation sémantique, le suivi des mouvements et la reconnaissance faciale. Cela est attribuable à l’efficacité des RNC pour accomplir de telles tâches, car ils peuvent réduire le nombre de paramètres sans réduire la qualité des modèles obtenus (Voulodimos et coll., 2018). Ceci est important en raison de la grande dimensionnalité des images. La dimensionnalité fait référence au nombre de caractéristiques (variables) utilisées comme données d’entrée du modèle de prédiction ou de classification. Lorsque des images sont utilisées comme données d’entrée d’un modèle, le nombre de caractéristiques correspond généralement au nombre de valeurs de couleur des pixels contenus dans l’image. Par exemple, dans le cas d’une image rouge-vert-bleu de 512 x 512 pixels, le nombre de caractéristiques serait le nombre de pixels multiplié par trois (en raison de trois canaux de couleur), ce qui correspond à 786 432. Il s’agit d’un nombre élevé de caractéristiques et, par conséquent, l’utilisation de techniques de traitement efficaces dans un tel cas est cruciale.

Description de la figure 2

Cette figure illustre un exemple de réseau neuronal composé d’une couche d’entrée, de deux couches cachées et d’une couche de sortie.Un réseau neuronal est composé d’un groupe de nœuds connectés ou d’unités appelées neurones artificiels (Dong et coll., 2021). Ces neurones imitent grossièrement les neurones d’un cerveau biologique. Un neurone artificiel reçoit un signal, une valeur, un nombre réel ou un ensemble de signaux, puis traite les données d’entrée, c’est-à-dire qu’il applique une fonction non linéaire, qu’il peut envoyer à d’autres neurones connectés à lui. La figure |2 montre un exemple de réseau neuronal. Les neurones sont généralement agencés en couches, et les couches peuvent effectuer différentes transformations à partir des données d’entrée reçues. Les signaux sont reçus par la couche d’entrée, puis traversent une ou plusieurs couches cachées avant d’atteindre la couche de sortie. Un réseau neuronal profond est un réseau neuronal composé de plusieurs couches cachées. Les couches entièrement connectées sont couramment utilisées dans les réseaux neuronaux profonds. Comme leur nom l’indique, les neurones d’une couche entièrement connectée sont entièrement connectés aux données de sortie de la couche précédente (voir la figure 2). Les données de sortie d’une couche entièrement connectée peuvent être utilisées comme résultats de classification ou alimenter une autre couche.

Un RNC est un type de réseau neuronal profond généralement composé de trois types de couches : les couches convolutives, les couches de sous-échantillonnage et les couches entièrement connectées (Voulodimos et coll., 2018). Une couche entièrement connectée est généralement précédée par les deux premiers types qui prennent les données d’entrée (généralement une image) et les transforment en un vecteur de caractéristiques. Les couches de sous-échantillonnage sont généralement insérées entre les couches de convolution. Elles effectuent un sous-échantillonnage sur les données d’entrée d’une couche de convolution pour en réduire la dimension. Cette réduction de la dimension spatiale a deux objectifs : elle réduit la complexité numérique et réduit également le surajustement Note . Les couches entièrement connectées sont souvent utilisées après les couches de convolution et de sous-échantillonnage pour transformer les cartes d’attributs bidimensionnelles en un vecteur de caractéristiques unidimensionnel.

3 Entraînement des réseaux neuronaux convolutifs pour la classification des types d’immeubles

3.1 Ensemble de données utilisé

Les images prises à partir de la rue facilement accessibles sont de plus en plus répandues. Depuis quelques années, plusieurs plateformes d’images prises à partir de la rue sont apparues; elles proposent différentes modalités de services et des degrés variés de « libre accès ». Google Street View (Google, 2020), Mapillary (Mapillary, 2014) et OpenStreetCam (Grab Holdings, 2009) en sont des exemples. Les images prises à partir de la rue offrent des possibilités remarquables d’enrichir les données sur les bâtiments par des renseignements complémentaires pertinents permettant d’autres analyses économiques et spatiales. De plus, elles sont utilisables à grande échelle, car elles fournissent généralement une bonne couverture géographique et elles sont facilement accessibles.

Dans une autre analyse menée par l’auteur du présent rapport, l’interface de programmation d’application (API) Google Street View Static a été utilisée pour produire des images d’essai dans le cadre d’un autre projet de vision par ordinateur (Al-Habashna, 2020, 2021) parce que l’API offre une vaste couverture, surtout dans les zones urbaines à l’échelle mondiale. L’API Google Street View Static permet de télécharger un panorama ou une vignette statique (non interactive) de la rue au moyen de requêtes HTTP (protocole de transfert hypertexte) (Google, 2020). On peut lancer une requête HTTP pour demander une image prise à partir de la rue et une image statique est renvoyée en réponse. Plusieurs paramètres peuvent être fournis dans la requête, comme l’inclinaison de la caméra (c.-à-d. l’angle de la caméra par rapport au véhicule Street View) et l’angle de vue (c.-à-d. l’étendue angulaire de la scène qui est photographiée par la caméra).

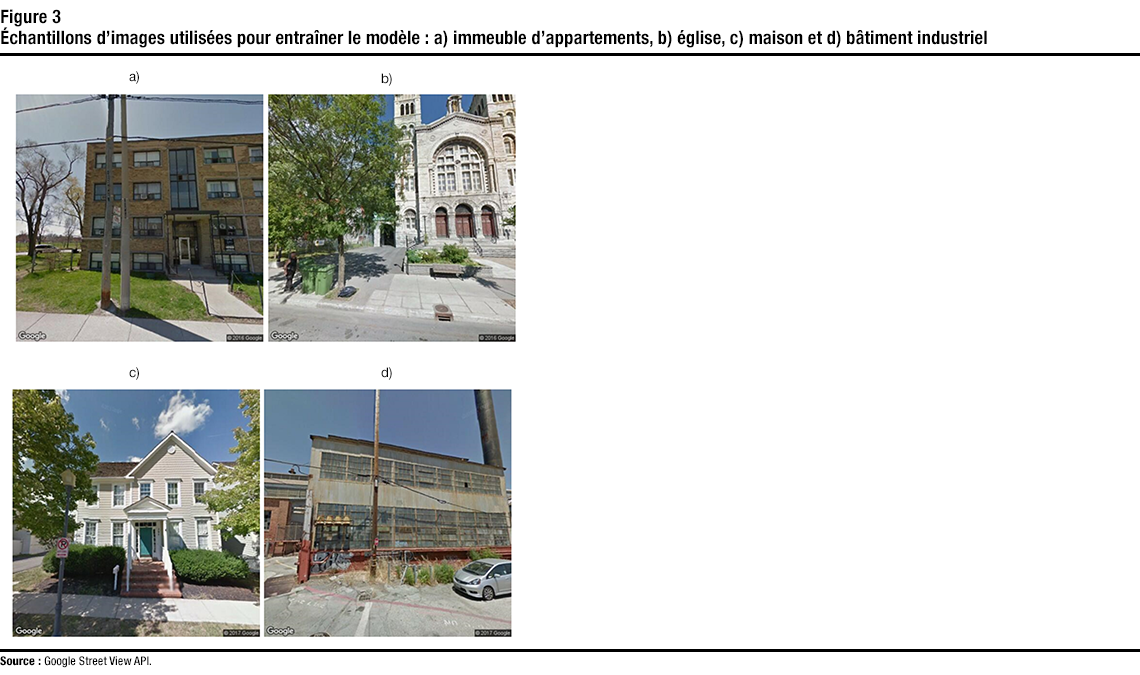

Description de la figure 3

Cette figure montre des échantillons d’images utilisées pour entraîner les modèles, c’est-à-dire des images au niveau de la rue : a) d’un appartement, b) d’une église, c) d’une maison, et d) de bâtiments industriels.La présente analyse utilise un grand ensemble d’images prises à partir de la rue générées par l’API Google Street View Static et rendues publiques par (Kang et coll., 2018). L’ensemble de données a été constitué et structuré de façon à être utilisé pour créer des modèles de classification des instances de bâtiments. L’ensemble de données de référence utilisé contient 19 658 images. Ces images proviennent de différentes villes du Canada et des États-Unis comme Montréal et New York. Les images sont réparties en huit classes différentes : immeubles d’appartements, églises, garages, maisons, constructions industrielles, immeubles de bureaux, commerces de détail et toitures. Les étiquettes de ces images ont été obtenues à partir d’OpenStreetMap (OSM) (OpenStreetMap, 2004). OSM attribue des étiquettes associées aux adresses (p. ex. maison, maison individuelle, immeuble d’appartements). Ces étiquettes ont été utilisées pour déduire la bonne étiquette associée à l’image. Par exemple, une image d’une adresse portant l’étiquette de maison individuelle est étiquetée comme une maison. Chaque classe comporte environ 2 500 images. Les images ont une résolution spatiale de 512 × 512 pixels et ont été prises avec la valeur d’inclinaison de 10 et la valeur d’angle de vue par défaut de 90 degrés. La figure 3 présente des échantillons d’images utilisées.

En raison de la méthode automatisée d’étiquetage utilisée pour préparer l’ensemble de données à partir des étiquettes d’OSM, il existe de nombreuses erreurs d’étiquetage dans l’ensemble de données d’entraînement (p. ex., une maison peut être étiquetée dans la catégorie immeubles d’appartements ou des garages). Par conséquent, l’étiquetage de l’ensemble de données a été examiné et corrigé manuellement. Dans la section 4, nous examinons plus en détail les erreurs d’étiquetage dans les ensembles d’entraînement, et montrons comment la correction de l’étiquetage des images peut améliorer considérablement la précision à la phase de classification par les modèles.

3.2 Réseaux neuronaux convolutifs entraînés

Comme l’entraînement d’un RNC comporte généralement des millions de paramètres et nécessite un très grand ensemble de données, le peaufinage des paramètres est une pratique courante lors de l’entraînement d’un RNC. Pour le peaufinage des paramètres, un modèle cible est créé à partir d’un modèle source. Le modèle cible est le modèle qui doit être entraîné, tandis que le modèle source est un modèle qui a déjà été entraîné pour un problème différent, mais pertinent. Le modèle source est utilisé comme point de départ, au lieu d’entraîner le modèle cible à partir de zéro. Par exemple, on peut utiliser un modèle de classification des animaux (chats, chiens, ours, etc.) comme modèle source, puis peaufiner les paramètres pour créer un modèle capable de classer les images de chiens en différentes races (golden retriever, labrador retriever, etc.).

Le modèle cible reproduit généralement tous les schémas de conception et leurs paramètres (p. ex. le nombre et la taille des couches cachées et leurs paramètres) du modèle source, à l’exception de la couche de sortie (Quinn, 2019). Cela est particulièrement utile lorsque les paramètres copiés qui contiennent les connaissances acquises de l’ensemble de données source sont applicables à l’ensemble de données cible. Comme la taille de la couche de sortie (nombre de neurones) d’un modèle de classification est généralement égale au nombre de classes, une couche de sortie dont la taille de sortie correspond au nombre de catégories de l’ensemble de données cible est utilisée dans le modèle cible pour tenir compte de la différence en ce qui concerne le nombre de classes entre le modèle source et le modèle cible. Par la suite, les paramètres de la couche de sortie sont initialisés aléatoirement, et les paramètres du modèle cible sont ensuite peaufinés avec l’ensemble de données cible.

De nombreux RNC ont été entraînés à partir de grands ensembles de données et peuvent être utilisés pour le peaufinage des paramètres. Des exemples de ce genre de RNC sont les RNC entraînés au moyen de l’ensemble de données ImageNet (Russakovsky et coll., 2015) qui peuvent être peaufinés au moyen d’ensembles de données plus petits utilisés à d’autres fins. Dans la présente analyse, plusieurs architectures de RNC de pointe ont été peaufinées au moyen de l’ensemble de données de construction dont il a été question ci-dessus. Pour ce faire, toutes les couches de convolution de ces RNC sont peaufinées, telles qu’elles ont été présentées par (Kang et coll., 2018). Cela inclut de multiples variations de l’architecture ResNet (He et coll., 2016)ainsi que de l’architecture VGG16 (Simonyan et coll., 2015).

Dans le présent rapport, deux modèles différents ont été entraînés en utilisant les architectures susmentionnées. Plusieurs versions du deuxième modèle ont également été entraînées pour comparer l’effet du réglage des hyperparamètres et de la correction de l’étiquetage. Voici la liste et la description des modèles élaborés :

- Modèle binaire : modèle binaire qui classe les immeubles en deux classes, soit les immeubles résidentiels et les immeubles non résidentiels.

- Modèle à classes multiples : modèle qui répartit les immeubles en huit classes différentes : immeubles d’appartements, églises, garages, maisons, constructions industrielles, immeubles de bureaux, commerces de détail et toitures. Les différentes versions de ce modèle sont répertoriées ci-dessous :

- Version 1 : Un modèle entraîné en utilisant les mêmes paramètres que dans (Kang et coll., 2018), sauf pour l’exclusion.

- Version 2 : Un modèle entraîné en utilisant des paramètres différents et qui a apporté certaines améliorations.

- Version 3 : Un modèle entraîné en utilisant les mêmes paramètres que ceux de la version 2, mais avec un ensemble de données qui a été mis à jour manuellement afin de corriger l’étiquetage.

4 Résultats

4.1 Modèle de classification binaire

Dans cette section, nous examinons les résultats du modèle binaire. Ce modèle classe les immeubles en deux classes, soit les immeubles résidentiels et les immeubles non résidentiels. À cette fin, l’ensemble d’images a été réparti en deux types. Le premier type est les immeubles résidentiels, qui comprennent les maisons et les immeubles d’appartements. Le deuxième type est les immeubles non résidentiels, qui comprennent les autres classes comme les immeubles de bureaux, les bâtiments industriels. Ensuite, l’ensemble de données a été utilisé pour peaufiner les architectures des RNC (c’est-à-dire ResNet18, ResNet34 et VGG16). Comme il a été mentionné précédemment, chaque classe de l’ensemble d’images contient environ 2 500 images. L’ensemble d’images a été divisé en un ensemble de données d’entraînement et un ensemble de données de validation, comprenant 80 % et 20 % des images respectivement. Les couches entièrement connectées de ces architectures ont été initialisées aléatoirement, tandis que les valeurs originales des paramètres des couches convolutives ont été utilisées. Les mêmes paramètres utilisés par (Kang et coll., 2018) ont été adoptés pour ce modèle. L’algorithme de descente de gradient stochastique a été utilisé avec un taux d’apprentissage de , une valeur de momentum de p = 0,9 et un facteur de dégradation (sur le taux d’apprentissage) de 0,1 par 30 époques. De plus, la perte d’entropie croisée a été utilisée pendant la phase d’entraînement avec une pénalisation de poids de 10-5. Les images d’entrée ont été réduites à 256 × 256 pixels. Par la suite, l’amplification des données a également été utilisée en recadrant aléatoirement les images d’entrée à 224 × 224 pixels et en appliquant aléatoirement un basculement horizontal sur les images rognées avant de les alimenter dans un réseau. Les RNC ont été déployés avec PyTorch (PyTorch, 2016) et entraînés sur un serveur Notebook doté d’un processeur graphique NVIDIA V100 de 32 Go.

La figure 4 montre la courbe d’apprentissage des phases d’entraînement et de validation des RNC entraînés jusqu’à 80 époques. Les courbes d’apprentissage montrent que tous les RNC convergent à compter de l’époque 40. Cela signifie qu’aucune autre amélioration (ou changement considérable) n’est réalisée en ce qui concerne les précisions pour tous les réseaux entraînés après l’époque 40. Le tableau 1 présente les meilleures précisions de validation et d’entraînement réalisées pour les trois architectures. D’après les courbes de précision à la phase d’entraînement et les résultats présentés dans le tableau, on constate que la meilleure précision à la phase d’entraînement a été obtenue par l’architecture ResNet34, qui a atteint une précision de 0,95. Cependant, les autres RNC ont obtenu des valeurs similaires de précision à la phase d’entraînement.

La précision à la phase de validation est la précision obtenue au moyen de l’ensemble de données de validation, qui est un ensemble de données que le modèle n’a pas vu durant la phase d’entraînement. Le RNC VGG16 a obtenu la meilleure précision à la phase de validation, soit 0,90. Les autres RNC ont obtenu des valeurs similaires de précision à la phase de validation.

Description de la figure 4

Cette figure contient trois sous-figures, chacune correspondant à une architecture différente (p. ex. ResNet-18). Chaque sous-figure montre la précision et la perte par rapport au numéro de la période (pour les phases d’entraînement et de validation) pour les modèles binaires entraînés. | Numéro de l’époque | ResNet18 | ResNet34 | VGG16 | |||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | |

| 1 | 0,758 | 0,803 | 0,497 | 0,424 | 0,767 | 0,810 | 0,481 | 0,407 | 0,760 | 0,818 | 0,491 | 0,408 |

| 2 | 0,817 | 0,829 | 0,409 | 0,389 | 0,823 | 0,829 | 0,392 | 0,375 | 0,815 | 0,830 | 0,406 | 0,369 |

| 3 | 0,825 | 0,827 | 0,385 | 0,375 | 0,843 | 0,832 | 0,358 | 0,370 | 0,834 | 0,835 | 0,375 | 0,360 |

| 4 | 0,838 | 0,842 | 0,366 | 0,358 | 0,846 | 0,852 | 0,344 | 0,347 | 0,839 | 0,850 | 0,357 | 0,324 |

| 5 | 0,844 | 0,852 | 0,353 | 0,337 | 0,860 | 0,854 | 0,323 | 0,326 | 0,853 | 0,859 | 0,337 | 0,320 |

| 6 | 0,854 | 0,859 | 0,338 | 0,327 | 0,869 | 0,849 | 0,306 | 0,342 | 0,855 | 0,855 | 0,329 | 0,337 |

| 7 | 0,858 | 0,851 | 0,326 | 0,335 | 0,875 | 0,863 | 0,292 | 0,315 | 0,861 | 0,871 | 0,318 | 0,299 |

| 8 | 0,858 | 0,861 | 0,323 | 0,323 | 0,876 | 0,860 | 0,288 | 0,316 | 0,862 | 0,866 | 0,313 | 0,302 |

| 9 | 0,865 | 0,861 | 0,315 | 0,310 | 0,880 | 0,867 | 0,283 | 0,314 | 0,867 | 0,874 | 0,306 | 0,299 |

| 10 | 0,867 | 0,869 | 0,308 | 0,311 | 0,886 | 0,866 | 0,269 | 0,318 | 0,872 | 0,866 | 0,294 | 0,300 |

| 11 | 0,869 | 0,864 | 0,302 | 0,306 | 0,887 | 0,875 | 0,262 | 0,297 | 0,877 | 0,874 | 0,285 | 0,291 |

| 12 | 0,871 | 0,868 | 0,295 | 0,305 | 0,888 | 0,870 | 0,256 | 0,303 | 0,882 | 0,879 | 0,279 | 0,290 |

| 13 | 0,874 | 0,863 | 0,288 | 0,301 | 0,897 | 0,866 | 0,248 | 0,325 | 0,882 | 0,874 | 0,277 | 0,291 |

| 14 | 0,879 | 0,870 | 0,282 | 0,303 | 0,899 | 0,873 | 0,241 | 0,311 | 0,888 | 0,881 | 0,263 | 0,275 |

| 15 | 0,885 | 0,858 | 0,276 | 0,323 | 0,900 | 0,877 | 0,235 | 0,307 | 0,888 | 0,883 | 0,266 | 0,282 |

| 16 | 0,889 | 0,859 | 0,269 | 0,306 | 0,905 | 0,880 | 0,226 | 0,298 | 0,892 | 0,876 | 0,262 | 0,291 |

| 17 | 0,887 | 0,856 | 0,269 | 0,315 | 0,909 | 0,869 | 0,218 | 0,319 | 0,894 | 0,878 | 0,251 | 0,277 |

| 18 | 0,887 | 0,872 | 0,258 | 0,303 | 0,913 | 0,879 | 0,210 | 0,311 | 0,891 | 0,878 | 0,255 | 0,281 |

| 19 | 0,894 | 0,862 | 0,256 | 0,316 | 0,913 | 0,871 | 0,208 | 0,315 | 0,890 | 0,884 | 0,253 | 0,277 |

| 20 | 0,891 | 0,865 | 0,256 | 0,299 | 0,915 | 0,871 | 0,203 | 0,310 | 0,896 | 0,883 | 0,249 | 0,277 |

| 21 | 0,894 | 0,874 | 0,251 | 0,298 | 0,915 | 0,872 | 0,207 | 0,325 | 0,899 | 0,883 | 0,236 | 0,273 |

| 22 | 0,898 | 0,863 | 0,244 | 0,314 | 0,919 | 0,879 | 0,195 | 0,301 | 0,897 | 0,876 | 0,241 | 0,286 |

| 23 | 0,899 | 0,869 | 0,242 | 0,304 | 0,919 | 0,871 | 0,192 | 0,317 | 0,903 | 0,873 | 0,235 | 0,285 |

| 24 | 0,902 | 0,873 | 0,237 | 0,297 | 0,923 | 0,880 | 0,190 | 0,320 | 0,898 | 0,874 | 0,238 | 0,298 |

| 25 | 0,906 | 0,872 | 0,229 | 0,301 | 0,925 | 0,878 | 0,177 | 0,313 | 0,907 | 0,884 | 0,228 | 0,275 |

| 26 | 0,905 | 0,866 | 0,230 | 0,305 | 0,921 | 0,878 | 0,186 | 0,310 | 0,907 | 0,880 | 0,220 | 0,281 |

| 27 | 0,906 | 0,875 | 0,221 | 0,307 | 0,927 | 0,875 | 0,174 | 0,338 | 0,908 | 0,885 | 0,221 | 0,279 |

| 28 | 0,905 | 0,871 | 0,226 | 0,310 | 0,932 | 0,874 | 0,169 | 0,335 | 0,907 | 0,881 | 0,221 | 0,296 |

| 29 | 0,908 | 0,867 | 0,220 | 0,314 | 0,931 | 0,873 | 0,165 | 0,331 | 0,906 | 0,880 | 0,218 | 0,296 |

| 30 | 0,908 | 0,874 | 0,213 | 0,309 | 0,932 | 0,875 | 0,161 | 0,329 | 0,911 | 0,879 | 0,210 | 0,289 |

| 31 | 0,915 | 0,887 | 0,206 | 0,291 | 0,938 | 0,874 | 0,153 | 0,334 | 0,919 | 0,887 | 0,196 | 0,276 |

| 32 | 0,911 | 0,878 | 0,209 | 0,300 | 0,939 | 0,882 | 0,147 | 0,320 | 0,918 | 0,895 | 0,199 | 0,266 |

| 33 | 0,915 | 0,872 | 0,207 | 0,298 | 0,936 | 0,883 | 0,151 | 0,318 | 0,922 | 0,886 | 0,191 | 0,275 |

| 34 | 0,916 | 0,868 | 0,201 | 0,307 | 0,943 | 0,880 | 0,140 | 0,322 | 0,918 | 0,890 | 0,192 | 0,271 |

| 35 | 0,914 | 0,873 | 0,203 | 0,300 | 0,941 | 0,883 | 0,144 | 0,324 | 0,921 | 0,903 | 0,195 | 0,262 |

| 36 | 0,914 | 0,872 | 0,205 | 0,300 | 0,944 | 0,882 | 0,138 | 0,332 | 0,920 | 0,888 | 0,193 | 0,268 |

| 37 | 0,917 | 0,879 | 0,201 | 0,295 | 0,940 | 0,882 | 0,145 | 0,328 | 0,918 | 0,895 | 0,194 | 0,262 |

| 38 | 0,919 | 0,882 | 0,193 | 0,297 | 0,940 | 0,883 | 0,145 | 0,323 | 0,923 | 0,891 | 0,186 | 0,261 |

| 39 | 0,918 | 0,871 | 0,199 | 0,296 | 0,943 | 0,887 | 0,140 | 0,320 | 0,922 | 0,889 | 0,187 | 0,272 |

| 40 | 0,916 | 0,883 | 0,201 | 0,294 | 0,945 | 0,878 | 0,138 | 0,327 | 0,923 | 0,891 | 0,187 | 0,269 |

| 41 | 0,919 | 0,871 | 0,197 | 0,317 | 0,945 | 0,874 | 0,138 | 0,338 | 0,923 | 0,884 | 0,188 | 0,298 |

| 42 | 0,917 | 0,878 | 0,196 | 0,301 | 0,946 | 0,879 | 0,138 | 0,330 | 0,923 | 0,881 | 0,190 | 0,281 |

| 43 | 0,920 | 0,880 | 0,198 | 0,309 | 0,942 | 0,875 | 0,142 | 0,351 | 0,923 | 0,896 | 0,185 | 0,270 |

| 44 | 0,916 | 0,871 | 0,198 | 0,322 | 0,945 | 0,876 | 0,133 | 0,342 | 0,923 | 0,882 | 0,184 | 0,286 |

| 45 | 0,919 | 0,876 | 0,196 | 0,300 | 0,945 | 0,890 | 0,135 | 0,303 | 0,925 | 0,886 | 0,184 | 0,288 |

| 46 | 0,919 | 0,871 | 0,193 | 0,306 | 0,942 | 0,876 | 0,139 | 0,339 | 0,922 | 0,892 | 0,186 | 0,288 |

| 47 | 0,920 | 0,878 | 0,197 | 0,295 | 0,944 | 0,875 | 0,139 | 0,331 | 0,922 | 0,878 | 0,190 | 0,292 |

| 48 | 0,920 | 0,869 | 0,194 | 0,304 | 0,944 | 0,883 | 0,135 | 0,337 | 0,924 | 0,895 | 0,188 | 0,273 |

| 49 | 0,920 | 0,874 | 0,194 | 0,302 | 0,946 | 0,883 | 0,135 | 0,323 | 0,927 | 0,892 | 0,182 | 0,267 |

| 50 | 0,923 | 0,874 | 0,190 | 0,298 | 0,944 | 0,883 | 0,138 | 0,324 | 0,923 | 0,884 | 0,182 | 0,285 |

| 51 | 0,920 | 0,888 | 0,194 | 0,286 | 0,945 | 0,883 | 0,138 | 0,340 | 0,924 | 0,883 | 0,181 | 0,278 |

| 52 | 0,918 | 0,879 | 0,193 | 0,300 | 0,942 | 0,880 | 0,140 | 0,339 | 0,927 | 0,890 | 0,180 | 0,281 |

| 53 | 0,922 | 0,873 | 0,192 | 0,311 | 0,944 | 0,880 | 0,132 | 0,311 | 0,924 | 0,885 | 0,184 | 0,276 |

| 54 | 0,921 | 0,876 | 0,193 | 0,301 | 0,944 | 0,871 | 0,136 | 0,364 | 0,924 | 0,893 | 0,182 | 0,280 |

| 55 | 0,922 | 0,875 | 0,191 | 0,310 | 0,945 | 0,874 | 0,132 | 0,347 | 0,925 | 0,890 | 0,181 | 0,277 |

| 56 | 0,918 | 0,875 | 0,191 | 0,303 | 0,945 | 0,880 | 0,136 | 0,343 | 0,924 | 0,890 | 0,185 | 0,280 |

| 57 | 0,924 | 0,885 | 0,192 | 0,288 | 0,943 | 0,875 | 0,138 | 0,349 | 0,925 | 0,890 | 0,182 | 0,267 |

| 58 | 0,917 | 0,891 | 0,194 | 0,283 | 0,947 | 0,876 | 0,134 | 0,340 | 0,924 | 0,893 | 0,186 | 0,274 |

| 59 | 0,924 | 0,868 | 0,188 | 0,305 | 0,943 | 0,884 | 0,135 | 0,336 | 0,926 | 0,891 | 0,180 | 0,290 |

| 60 | 0,921 | 0,874 | 0,190 | 0,294 | 0,946 | 0,874 | 0,135 | 0,342 | 0,927 | 0,894 | 0,172 | 0,271 |

| 61 | 0,919 | 0,872 | 0,191 | 0,316 | 0,947 | 0,874 | 0,131 | 0,341 | 0,925 | 0,888 | 0,179 | 0,281 |

| 62 | 0,919 | 0,877 | 0,188 | 0,299 | 0,943 | 0,877 | 0,141 | 0,350 | 0,925 | 0,890 | 0,180 | 0,278 |

| 63 | 0,926 | 0,878 | 0,186 | 0,302 | 0,943 | 0,870 | 0,134 | 0,352 | 0,927 | 0,884 | 0,176 | 0,285 |

| 64 | 0,923 | 0,881 | 0,188 | 0,303 | 0,942 | 0,879 | 0,135 | 0,338 | 0,929 | 0,888 | 0,176 | 0,284 |

| 65 | 0,923 | 0,874 | 0,187 | 0,306 | 0,944 | 0,876 | 0,137 | 0,341 | 0,929 | 0,888 | 0,172 | 0,287 |

| 66 | 0,917 | 0,874 | 0,191 | 0,291 | 0,944 | 0,875 | 0,136 | 0,346 | 0,926 | 0,886 | 0,178 | 0,277 |

| 67 | 0,924 | 0,873 | 0,189 | 0,307 | 0,944 | 0,874 | 0,134 | 0,359 | 0,929 | 0,884 | 0,174 | 0,294 |

| 68 | 0,919 | 0,876 | 0,193 | 0,310 | 0,945 | 0,883 | 0,138 | 0,345 | 0,924 | 0,892 | 0,179 | 0,269 |

| 69 | 0,923 | 0,870 | 0,188 | 0,314 | 0,948 | 0,883 | 0,132 | 0,322 | 0,927 | 0,887 | 0,173 | 0,277 |

| 70 | 0,921 | 0,879 | 0,192 | 0,305 | 0,943 | 0,879 | 0,138 | 0,329 | 0,924 | 0,886 | 0,177 | 0,272 |

| 71 | 0,921 | 0,878 | 0,189 | 0,290 | 0,946 | 0,876 | 0,129 | 0,345 | 0,926 | 0,882 | 0,176 | 0,287 |

| 72 | 0,922 | 0,883 | 0,188 | 0,298 | 0,943 | 0,881 | 0,135 | 0,335 | 0,925 | 0,887 | 0,178 | 0,286 |

| 73 | 0,920 | 0,879 | 0,189 | 0,280 | 0,945 | 0,882 | 0,132 | 0,341 | 0,926 | 0,888 | 0,175 | 0,278 |

| 74 | 0,921 | 0,874 | 0,190 | 0,296 | 0,947 | 0,875 | 0,134 | 0,348 | 0,930 | 0,891 | 0,172 | 0,285 |

| 75 | 0,921 | 0,876 | 0,192 | 0,302 | 0,946 | 0,876 | 0,131 | 0,341 | 0,930 | 0,886 | 0,171 | 0,298 |

| 76 | 0,922 | 0,877 | 0,187 | 0,298 | 0,947 | 0,879 | 0,130 | 0,349 | 0,929 | 0,895 | 0,173 | 0,270 |

| 77 | 0,922 | 0,875 | 0,188 | 0,307 | 0,944 | 0,874 | 0,137 | 0,354 | 0,926 | 0,882 | 0,176 | 0,282 |

| 78 | 0,919 | 0,866 | 0,192 | 0,321 | 0,947 | 0,878 | 0,129 | 0,328 | 0,927 | 0,896 | 0,176 | 0,283 |

| 79 | 0,923 | 0,876 | 0,186 | 0,308 | 0,946 | 0,874 | 0,132 | 0,357 | 0,927 | 0,884 | 0,175 | 0,286 |

| 80 | 0,923 | 0,875 | 0,189 | 0,296 | 0,944 | 0,882 | 0,137 | 0,326 | 0,928 | 0,881 | 0,174 | 0,303 |

| Architecture | Précision à la phase d’entraînement | Précision à la phase de validation |

|---|---|---|

| ResNet18 | 0,93 | 0,89 |

| ResNet34 | 0,95 | 0,89 |

| VGG16 | 0,93 | 0,90 |

Aucun des RNC peaufinés ne montre un comportement de surajustement important, le VGG16 présentant la plus petite différence entre la précision d’entraînement et de validation. Le surajustement est un résultat indésirable de l’entraînement du modèle qui survient lorsque le modèle représente trop bien les données d’entraînement au lieu de les représenter de façon générique et de fournir une grande précision à la phase de prédiction ou de classification pour tout ensemble de données. L’architecture ResNet34 présente la plus grande différence entre la précision à la phase d’entraînement et à la phase de validation en raison du nombre élevé de paramètres dans ce réseau.

4.2 Modèle à classes multiples

Comme il a été mentionné précédemment, un deuxième modèle a été construit avec quatre architectures RNC pour classer les bâtiments en huit types : immeubles d’appartements, églises, garages, maisons, constructions industrielles, immeubles de bureaux, commerces de détail et toitures. Trois versions de chaque architecture RNC ont été entraînées. Les trois versions du modèle à classes multiples sont présentées de nouveau ici pour plus de clarté :

- Version 1 : Un modèle entraîné en utilisant les mêmes paramètres que dans (Kang et coll., 2018), sauf pour l’exclusion.

- Version 2 : Un modèle entraîné en utilisant des paramètres différents et qui a apporté certaines améliorations.

- Version 3 : Un modèle entraîné en utilisant les mêmes paramètres que ceux de la version 2, mais avec un ensemble de données qui a été mis à jour manuellement afin de corriger l’étiquetage.

Version 1

La figure 5 montre la courbe d’apprentissage des phases d’entraînement et de validation des RNC entraînés (c’est-à-dire ResNet18, ResNet34, ResNet50 et VGG16) jusqu’à 80 époques. Les courbes d’apprentissage montrent que tous les RNC convergent à compter de l’époque 60, c’est-à-dire qu’aucune autre amélioration n’est réalisée en ce qui concerne les précisions pour tous les réseaux entraînés après l’époque 60. Les meilleures précisions de validation et d’entraînement obtenues pour tous les RNC entraînés sont également présentées dans le tableau 2. D’après les courbes de précision à la phase d’entraînement et les résultats présentés dans le tableau, on constate que la meilleure précision à la phase d’entraînement a été obtenue par l’architecture ResNet50, qui a atteint une précision de 0,92. Les autres RNC ont obtenu une précision d’entraînement d’environ 0,80. La précision à la phase de validation est la précision obtenue au moyen de l’ensemble de données de validation, qui est un ensemble de données que le modèle n’a pas vu durant la phase d’entraînement. La meilleure précision à la phase de validation (0,70) a été obtenue par les architectures VGG16 et ResNet50, tandis que les autres RNC ont obtenu des précisions à la phase de validation similaires (0,67 pour ResNet et 0,69 pour ResNet34). Les résultats montrent qu’un certain surajustement peut être observé pour les architectures ResNet34 et ResNet50. Comme nous l’avons expliqué précédemment, le surajustement est un résultat indésirable de l’entraînement du modèle qui survient lorsque le modèle représente trop bien les données d’entraînement au lieu de les représenter de façon générique et de fournir une grande précision à la phase de prédiction ou de classification pour tout ensemble de données. Pour les architectures ResNet34 et ResNet50, le surajustement survient lorsque la précision à la phase d’entraînement est supérieure à la précision à la phase de validation. Ces résultats découlent du grand nombre de paramètres dans ces réseaux.

La figure 6 présente des échantillons des résultats obtenus à partir d’un ensemble de données de test. L’ensemble de données de test comprend des images recueillies dans des villes autres que celles qui font partie de l’ensemble de données d’entraînement. Les résultats présentés ici ont été obtenus par l’architecture VGG16, car elle affichait la meilleure précision à la phase de validation et le comportement de surajustement le plus faible. L’ensemble de données de test comprend environ 2 000 images (chaque classe comporte environ 250 images). La précision à la phase de classification obtenue par l’architecture VGG16 au moyen de cet ensemble était de 0,59, ce qui correspond aux résultats obtenus par (Kang et coll., 2018). La figure 6 présente des échantillons des résultats obtenus par l’architecture VGG16 à partir de l’ensemble de données de test susmentionné. Les échantillons montrent de nombreux exemples de cas où le modèle a correctement classé les images. Cependant, dans certains cas, les images ont été mal classées. Par exemple, un garage peut être mal classé dans la classe des maisons (ou vice versa), car, dans la plupart des cas, le garage est attenant à une maison. L’image dans le coin supérieur droit représente une construction résidentielle qui, initialement, a été mal placée dans la classe des toitures. L’examen de l’ensemble de données (ensembles de données d’entraînement et de test) a montré que de nombreuses images sont mal étiquetées. Par conséquent, une correction manuelle de l’étiquetage des données est effectuée, et un nouveau modèle (version 3) est entraîné à partir de l’ensemble de données amélioré.

Description de la figure 5

Cette figure contient quatre sous-figures, chacune correspondant à une architecture différente (p. ex. ResNet-18). Chaque sous-figure montre la précision et la perte par rapport au numéro de la période (pour les phases d’entraînement et de validation) pour les modèles entraînés à classes multiples (version 1). | Numéro de l’époque | ResNet18 | ResNet34 | ResNet50 | VGG16 | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | |

| 1 | 0,369 | 0,501 | 1 723 | 1 435 | 0,401 | 0,526 | 1 655 | 1 369 | 0,496 | 0,594 | 1 419 | 1 186 | 0,379 | 0,517 | 1 695 | 1 376 |

| 2 | 0,526 | 0,550 | 1 356 | 1 284 | 0,550 | 0,571 | 1 287 | 1 239 | 0,605 | 0,625 | 1 142 | 1 117 | 0,510 | 0,560 | 1 375 | 1 254 |

| 3 | 0,569 | 0,574 | 1 235 | 1 232 | 0,589 | 0,595 | 1 178 | 1,170 | 0,631 | 0,641 | 1 065 | 1 089 | 0,552 | 0,579 | 1 272 | 1 193 |

| 4 | 0,590 | 0,583 | 1 178 | 1 174 | 0,615 | 0,623 | 1 105 | 1 116 | 0,655 | 0,645 | 1 011 | 1 072 | 0,578 | 0,597 | 1 209 | 1 144 |

| 5 | 0,606 | 0,594 | 1,140 | 1 157 | 0,632 | 0,613 | 1 059 | 1 108 | 0,675 | 0,652 | 0,946 | 1 067 | 0,597 | 0,610 | 1 165 | 1 133 |

| 6 | 0,620 | 0,605 | 1 093 | 1 138 | 0,645 | 0,629 | 1 027 | 1 083 | 0,697 | 0,648 | 0,897 | 1 073 | 0,614 | 0,622 | 1 122 | 1 087 |

| 7 | 0,631 | 0,616 | 1,070 | 1 114 | 0,664 | 0,630 | 0,981 | 1 038 | 0,699 | 0,658 | 0,864 | 1 058 | 0,613 | 0,631 | 1 097 | 1 078 |

| 8 | 0,639 | 0,618 | 1 047 | 1 093 | 0,669 | 0,642 | 0,963 | 1 065 | 0,716 | 0,657 | 0,829 | 1 043 | 0,633 | 0,637 | 1,070 | 1 069 |

| 9 | 0,647 | 0,625 | 1 021 | 1 091 | 0,682 | 0,644 | 0,935 | 1 034 | 0,727 | 0,664 | 0,801 | 1,040 | 0,633 | 0,633 | 1 059 | 1 048 |

| 10 | 0,658 | 0,627 | 0,999 | 1 091 | 0,692 | 0,641 | 0,904 | 1 049 | 0,733 | 0,661 | 0,771 | 1 065 | 0,646 | 0,639 | 1 021 | 1 053 |

| 11 | 0,661 | 0,633 | 0,981 | 1 076 | 0,699 | 0,649 | 0,884 | 1 025 | 0,742 | 0,659 | 0,742 | 1,070 | 0,651 | 0,641 | 1 007 | 1 024 |

| 12 | 0,668 | 0,638 | 0,965 | 1 069 | 0,703 | 0,647 | 0,866 | 1 021 | 0,751 | 0,658 | 0,716 | 1 099 | 0,661 | 0,647 | 0,989 | 1 026 |

| 13 | 0,678 | 0,637 | 0,946 | 1 073 | 0,710 | 0,650 | 0,841 | 1,010 | 0,765 | 0,656 | 0,689 | 1,080 | 0,669 | 0,648 | 0,962 | 1 021 |

| 14 | 0,677 | 0,629 | 0,938 | 1 074 | 0,716 | 0,658 | 0,824 | 0,996 | 0,779 | 0,658 | 0,643 | 1 126 | 0,674 | 0,657 | 0,947 | 1 017 |

| 15 | 0,681 | 0,637 | 0,921 | 1 049 | 0,725 | 0,654 | 0,798 | 1,020 | 0,776 | 0,651 | 0,640 | 1 141 | 0,677 | 0,655 | 0,940 | 1 021 |

| 16 | 0,688 | 0,635 | 0,899 | 1 056 | 0,725 | 0,653 | 0,792 | 0,993 | 0,788 | 0,652 | 0,615 | 1 145 | 0,679 | 0,650 | 0,925 | 1 019 |

| 17 | 0,695 | 0,641 | 0,889 | 1 058 | 0,736 | 0,663 | 0,771 | 1 035 | 0,798 | 0,664 | 0,587 | 1 132 | 0,691 | 0,661 | 0,906 | 0,998 |

| 18 | 0,702 | 0,642 | 0,869 | 1 029 | 0,747 | 0,660 | 0,743 | 1 008 | 0,800 | 0,649 | 0,575 | 1 236 | 0,690 | 0,659 | 0,900 | 0,982 |

| 19 | 0,702 | 0,646 | 0,863 | 1 052 | 0,752 | 0,670 | 0,726 | 1 016 | 0,807 | 0,661 | 0,549 | 1 186 | 0,703 | 0,665 | 0,874 | 0,985 |

| 20 | 0,705 | 0,656 | 0,853 | 1 034 | 0,753 | 0,648 | 0,714 | 1 045 | 0,812 | 0,665 | 0,527 | 1 179 | 0,701 | 0,662 | 0,867 | 0,975 |

| 21 | 0,714 | 0,633 | 0,836 | 1 065 | 0,762 | 0,656 | 0,695 | 1 025 | 0,816 | 0,657 | 0,519 | 1 209 | 0,709 | 0,672 | 0,844 | 0,998 |

| 22 | 0,713 | 0,643 | 0,829 | 1 044 | 0,766 | 0,663 | 0,680 | 1 026 | 0,825 | 0,650 | 0,503 | 1 289 | 0,708 | 0,660 | 0,838 | 0,986 |

| 23 | 0,720 | 0,657 | 0,816 | 1 029 | 0,773 | 0,667 | 0,659 | 1 045 | 0,830 | 0,665 | 0,486 | 1 179 | 0,714 | 0,666 | 0,829 | 0,979 |

| 24 | 0,731 | 0,652 | 0,791 | 1 035 | 0,779 | 0,677 | 0,638 | 1 043 | 0,829 | 0,671 | 0,485 | 1 219 | 0,719 | 0,667 | 0,814 | 0,997 |

| 25 | 0,727 | 0,655 | 0,788 | 1 028 | 0,778 | 0,667 | 0,627 | 1 039 | 0,838 | 0,659 | 0,464 | 1 335 | 0,717 | 0,676 | 0,812 | 0,969 |

| 26 | 0,733 | 0,654 | 0,777 | 1 047 | 0,786 | 0,663 | 0,617 | 1 044 | 0,847 | 0,666 | 0,437 | 1 278 | 0,727 | 0,674 | 0,790 | 0,973 |

| 27 | 0,740 | 0,639 | 0,755 | 1 052 | 0,791 | 0,655 | 0,598 | 1 073 | 0,852 | 0,671 | 0,431 | 1 263 | 0,731 | 0,667 | 0,783 | 0,974 |

| 28 | 0,741 | 0,653 | 0,754 | 1 046 | 0,798 | 0,668 | 0,584 | 1 042 | 0,845 | 0,675 | 0,437 | 1 286 | 0,734 | 0,669 | 0,778 | 1 003 |

| 29 | 0,747 | 0,650 | 0,735 | 1 043 | 0,804 | 0,662 | 0,568 | 1 089 | 0,856 | 0,660 | 0,410 | 1 278 | 0,736 | 0,673 | 0,763 | 0,973 |

| 30 | 0,750 | 0,657 | 0,723 | 1 033 | 0,809 | 0,673 | 0,543 | 1 078 | 0,859 | 0,660 | 0,404 | 1 348 | 0,739 | 0,678 | 0,748 | 0,988 |

| 31 | 0,762 | 0,655 | 0,692 | 1 019 | 0,818 | 0,675 | 0,525 | 1 057 | 0,881 | 0,676 | 0,340 | 1 223 | 0,751 | 0,674 | 0,717 | 0,989 |

| 32 | 0,767 | 0,647 | 0,688 | 1 054 | 0,819 | 0,677 | 0,523 | 1,050 | 0,893 | 0,687 | 0,315 | 1 227 | 0,751 | 0,686 | 0,714 | 0,968 |

| 33 | 0,762 | 0,661 | 0,694 | 1 037 | 0,825 | 0,674 | 0,502 | 1,050 | 0,900 | 0,684 | 0,295 | 1 246 | 0,744 | 0,678 | 0,727 | 0,983 |

| 34 | 0,762 | 0,667 | 0,692 | 1 017 | 0,825 | 0,672 | 0,509 | 1 068 | 0,895 | 0,684 | 0,303 | 1 247 | 0,750 | 0,684 | 0,718 | 0,970 |

| 35 | 0,769 | 0,659 | 0,675 | 1,040 | 0,826 | 0,674 | 0,504 | 1 052 | 0,898 | 0,696 | 0,299 | 1 187 | 0,750 | 0,673 | 0,711 | 0,991 |

| 36 | 0,766 | 0,666 | 0,689 | 1 035 | 0,835 | 0,684 | 0,496 | 1 029 | 0,904 | 0,684 | 0,285 | 1 232 | 0,755 | 0,673 | 0,708 | 0,995 |

| 37 | 0,767 | 0,664 | 0,681 | 1 023 | 0,830 | 0,674 | 0,496 | 1,060 | 0,905 | 0,694 | 0,281 | 1 248 | 0,748 | 0,682 | 0,721 | 0,974 |

| 38 | 0,762 | 0,663 | 0,683 | 1 029 | 0,825 | 0,669 | 0,498 | 1 048 | 0,907 | 0,687 | 0,274 | 1 225 | 0,758 | 0,679 | 0,702 | 0,984 |

| 39 | 0,766 | 0,646 | 0,675 | 1,060 | 0,835 | 0,672 | 0,488 | 1 075 | 0,906 | 0,683 | 0,275 | 1 278 | 0,755 | 0,685 | 0,704 | 0,957 |

| 40 | 0,768 | 0,651 | 0,674 | 1 033 | 0,834 | 0,669 | 0,487 | 1 086 | 0,907 | 0,695 | 0,265 | 1 226 | 0,760 | 0,682 | 0,701 | 0,959 |

| 41 | 0,770 | 0,665 | 0,679 | 1 018 | 0,832 | 0,666 | 0,485 | 1 093 | 0,906 | 0,685 | 0,275 | 1 323 | 0,753 | 0,679 | 0,701 | 0,980 |

| 42 | 0,766 | 0,656 | 0,681 | 1 049 | 0,831 | 0,668 | 0,488 | 1 067 | 0,906 | 0,674 | 0,276 | 1 267 | 0,758 | 0,681 | 0,702 | 0,986 |

| 43 | 0,769 | 0,657 | 0,674 | 1 037 | 0,837 | 0,671 | 0,482 | 1 069 | 0,908 | 0,682 | 0,274 | 1,250 | 0,761 | 0,683 | 0,690 | 0,986 |

| 44 | 0,769 | 0,666 | 0,674 | 1 044 | 0,839 | 0,672 | 0,473 | 1 074 | 0,909 | 0,691 | 0,263 | 1 276 | 0,758 | 0,666 | 0,702 | 1 005 |

| 45 | 0,771 | 0,657 | 0,666 | 1 023 | 0,840 | 0,671 | 0,477 | 1 072 | 0,909 | 0,692 | 0,265 | 1 266 | 0,758 | 0,684 | 0,696 | 0,987 |

| 46 | 0,765 | 0,668 | 0,677 | 1 024 | 0,835 | 0,677 | 0,478 | 1 055 | 0,912 | 0,683 | 0,261 | 1 295 | 0,760 | 0,683 | 0,691 | 0,967 |

| 47 | 0,766 | 0,665 | 0,677 | 1 032 | 0,838 | 0,669 | 0,473 | 1 099 | 0,913 | 0,687 | 0,261 | 1 299 | 0,758 | 0,672 | 0,691 | 0,992 |

| 48 | 0,770 | 0,668 | 0,667 | 1 022 | 0,838 | 0,667 | 0,480 | 1 085 | 0,913 | 0,682 | 0,253 | 1 306 | 0,759 | 0,674 | 0,692 | 0,998 |

| 49 | 0,770 | 0,647 | 0,668 | 1 043 | 0,841 | 0,671 | 0,466 | 1 075 | 0,912 | 0,689 | 0,253 | 1,290 | 0,761 | 0,681 | 0,685 | 0,982 |

| 50 | 0,768 | 0,659 | 0,672 | 1 027 | 0,840 | 0,671 | 0,474 | 1 088 | 0,918 | 0,689 | 0,241 | 1 323 | 0,762 | 0,676 | 0,678 | 0,990 |

| 51 | 0,778 | 0,656 | 0,661 | 1 043 | 0,841 | 0,670 | 0,469 | 1 081 | 0,916 | 0,695 | 0,253 | 1 245 | 0,763 | 0,684 | 0,682 | 0,966 |

| 52 | 0,777 | 0,655 | 0,646 | 1 042 | 0,842 | 0,665 | 0,463 | 1 096 | 0,918 | 0,691 | 0,239 | 1,260 | 0,764 | 0,678 | 0,685 | 0,983 |

| 53 | 0,771 | 0,667 | 0,665 | 1,030 | 0,839 | 0,678 | 0,462 | 1 082 | 0,914 | 0,691 | 0,250 | 1 293 | 0,762 | 0,672 | 0,691 | 0,993 |

| 54 | 0,773 | 0,666 | 0,659 | 1,040 | 0,845 | 0,673 | 0,461 | 1 079 | 0,916 | 0,683 | 0,252 | 1 298 | 0,763 | 0,680 | 0,687 | 0,980 |

| 55 | 0,775 | 0,659 | 0,652 | 1 059 | 0,841 | 0,678 | 0,461 | 1 077 | 0,918 | 0,690 | 0,243 | 1 301 | 0,766 | 0,677 | 0,672 | 0,999 |

| 56 | 0,775 | 0,661 | 0,655 | 1 047 | 0,849 | 0,668 | 0,446 | 1 071 | 0,916 | 0,687 | 0,244 | 1,310 | 0,762 | 0,678 | 0,678 | 0,974 |

| 57 | 0,774 | 0,652 | 0,650 | 1 052 | 0,840 | 0,672 | 0,466 | 1 095 | 0,916 | 0,689 | 0,243 | 1 318 | 0,765 | 0,680 | 0,673 | 0,980 |

| 58 | 0,776 | 0,660 | 0,651 | 1 032 | 0,840 | 0,668 | 0,466 | 1 097 | 0,916 | 0,686 | 0,238 | 1 302 | 0,764 | 0,675 | 0,675 | 0,997 |

| 59 | 0,781 | 0,670 | 0,650 | 1 027 | 0,845 | 0,674 | 0,458 | 1 083 | 0,918 | 0,688 | 0,242 | 1 276 | 0,767 | 0,679 | 0,675 | 0,993 |

| 60 | 0,775 | 0,657 | 0,648 | 1,060 | 0,844 | 0,682 | 0,454 | 1 056 | 0,917 | 0,692 | 0,242 | 1 314 | 0,770 | 0,673 | 0,668 | 1 007 |

| 61 | 0,777 | 0,661 | 0,646 | 1,070 | 0,848 | 0,679 | 0,447 | 1 098 | 0,923 | 0,689 | 0,234 | 1 315 | 0,766 | 0,677 | 0,671 | 0,993 |

| 62 | 0,780 | 0,654 | 0,640 | 1 052 | 0,844 | 0,667 | 0,453 | 1 081 | 0,919 | 0,698 | 0,237 | 1 257 | 0,766 | 0,678 | 0,676 | 0,991 |

| 63 | 0,780 | 0,659 | 0,644 | 1 037 | 0,852 | 0,670 | 0,440 | 1 086 | 0,917 | 0,689 | 0,244 | 1 303 | 0,763 | 0,683 | 0,679 | 1 005 |

| 64 | 0,785 | 0,662 | 0,632 | 1,050 | 0,850 | 0,667 | 0,447 | 1 079 | 0,918 | 0,697 | 0,239 | 1 279 | 0,765 | 0,667 | 0,674 | 1 024 |

| 65 | 0,778 | 0,670 | 0,648 | 1 033 | 0,847 | 0,672 | 0,450 | 1 089 | 0,921 | 0,690 | 0,236 | 1 308 | 0,770 | 0,677 | 0,661 | 1 007 |

| 66 | 0,780 | 0,664 | 0,643 | 1 053 | 0,846 | 0,677 | 0,455 | 1 089 | 0,917 | 0,690 | 0,241 | 1 289 | 0,772 | 0,688 | 0,663 | 0,988 |

| 67 | 0,778 | 0,664 | 0,647 | 1 049 | 0,846 | 0,669 | 0,451 | 1 085 | 0,921 | 0,692 | 0,228 | 1,340 | 0,769 | 0,685 | 0,664 | 0,972 |

| 68 | 0,781 | 0,661 | 0,634 | 1 057 | 0,843 | 0,687 | 0,453 | 1 044 | 0,923 | 0,688 | 0,225 | 1 282 | 0,768 | 0,683 | 0,668 | 0,993 |

| 69 | 0,785 | 0,656 | 0,636 | 1 049 | 0,850 | 0,675 | 0,451 | 1 051 | 0,919 | 0,688 | 0,233 | 1 254 | 0,770 | 0,691 | 0,663 | 0,961 |

| 70 | 0,779 | 0,659 | 0,640 | 1 051 | 0,848 | 0,668 | 0,442 | 1 084 | 0,921 | 0,689 | 0,233 | 1 333 | 0,766 | 0,662 | 0,670 | 1 012 |

| 71 | 0,779 | 0,662 | 0,645 | 1 053 | 0,843 | 0,673 | 0,456 | 1 073 | 0,919 | 0,691 | 0,235 | 1 313 | 0,766 | 0,680 | 0,674 | 0,984 |

| 72 | 0,780 | 0,665 | 0,642 | 1 046 | 0,842 | 0,665 | 0,460 | 1 098 | 0,921 | 0,692 | 0,235 | 1 282 | 0,762 | 0,677 | 0,677 | 0,985 |

| 73 | 0,783 | 0,663 | 0,638 | 1 025 | 0,847 | 0,670 | 0,457 | 1 113 | 0,923 | 0,691 | 0,226 | 1 301 | 0,770 | 0,679 | 0,663 | 0,985 |

| 74 | 0,784 | 0,648 | 0,632 | 1,050 | 0,846 | 0,665 | 0,444 | 1,120 | 0,918 | 0,696 | 0,239 | 1 292 | 0,769 | 0,687 | 0,665 | 0,980 |

| 75 | 0,779 | 0,656 | 0,646 | 1,050 | 0,842 | 0,676 | 0,456 | 1 086 | 0,916 | 0,699 | 0,240 | 1 277 | 0,771 | 0,681 | 0,663 | 0,993 |

| 76 | 0,779 | 0,658 | 0,639 | 1 056 | 0,848 | 0,679 | 0,441 | 1 108 | 0,922 | 0,691 | 0,228 | 1 274 | 0,767 | 0,674 | 0,670 | 1 012 |

| 77 | 0,777 | 0,659 | 0,646 | 1 034 | 0,846 | 0,677 | 0,444 | 1 077 | 0,923 | 0,693 | 0,225 | 1 306 | 0,768 | 0,688 | 0,669 | 0,973 |

| 78 | 0,781 | 0,654 | 0,645 | 1 053 | 0,850 | 0,683 | 0,444 | 1 083 | 0,922 | 0,699 | 0,232 | 1,320 | 0,766 | 0,684 | 0,672 | 0,976 |

| 79 | 0,780 | 0,670 | 0,639 | 1 018 | 0,846 | 0,665 | 0,447 | 1 077 | 0,922 | 0,693 | 0,238 | 1 293 | 0,768 | 0,681 | 0,666 | 0,991 |

| 80 | 0,775 | 0,659 | 0,653 | 1 046 | 0,852 | 0,672 | 0,439 | 1 101 | 0,923 | 0,678 | 0,225 | 1 329 | 0,769 | 0,684 | 0,663 | 0,980 |

| Architecture | Précision à la phase d’entraînement | Précision à la phase de validation |

|---|---|---|

| ResNet18 | 0,79 | 0,67 |

| ResNet34 | 0,85 | 0,69 |

| ResNet50 | 0,92 | 0,70 |

| VGG16 | 0,79 | 0,70 |

Description de la figure 6

Cette figure illustre les multiples échantillons d’images au niveau de la rue de différents immeubles, ainsi que leurs types réels et prédits.Version 2

Une deuxième version du modèle à classes multiples a été entraînée avec des paramètres différents. Dans ce modèle, le facteur de dégradation (sur le taux d’apprentissage) a été fixé à 0,1 par 5 époques. Le nombre d’époques a été fixé à 15, et la perte d’entropie croisée a été utilisée pendant la phase d’entraînement avec une pénalisation de poids de 10-3. Nous avons également éliminé le recadrage aléatoire des images (une partie de l’amplification des données), car il semblait avoir un effet négatif, et supprimé aléatoirement des caractéristiques dans les images de l’ensemble d’entraînement. Cela a eu une incidence sur la précision à la phase d’entraînement. De plus, une couche d’extinction de neurone a été introduite pour les RNC avec une probabilité d’exclusion de 0,15.

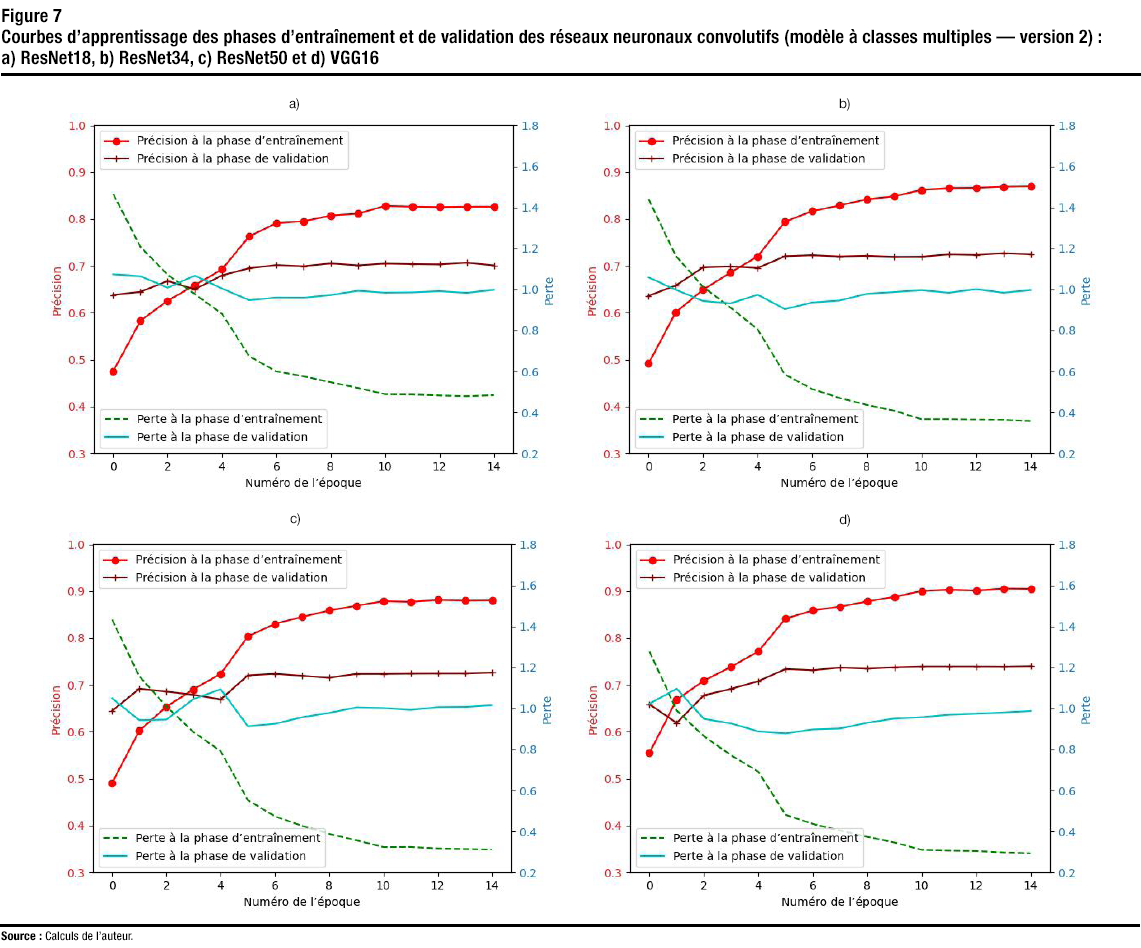

La figure 7 montre la courbe d’apprentissage des phases d’entraînement et de validation des RNC entraînés (c’est-à-dire ResNet18, ResNet34, ResNet50 et VGG16) jusqu’à 15 époques. Les courbes d’apprentissage montrent que tous les RNC convergent à compter de l’époque 12. Les meilleures précisions de validation et d’entraînement obtenues pour tous les RNC entraînés sont également présentées dans le tableau 3. D’après les courbes de précision à la phase d’entraînement et les résultats présentés dans le tableau, on constate que la meilleure précision à la phase d’entraînement a été obtenue par l’architecture VGG16, qui a atteint une précision de 0,91. D’autres RNC ont obtenu des précisions d’entraînement allant de 0,83 à 0,88. La meilleure précision à la phase de validation (0,74) a également été obtenue par l’architecture VGG16, tandis que les architectures ResNet34 et ResNet50 ont atteint une précision à la phase de validation de 0,73. Une amélioration considérable (jusqu’à 5,7 % d’augmentation par rapport à la première version) a été obtenue avec les nouveaux paramètres et l’approche d’augmentation des données. Cependant, on a également observé une augmentation de la précision à la phase d’entraînement pour tous les RNC (sauf ResNet50), malgré l’ajout d’une couche d’exclusion. L’augmentation de la précision à la phase d’entraînement était due à l’élimination du recadrage aléatoire à la suite duquel des caractéristiques distinctives des bâtiments ont pu être rognées de manière aléatoire.

Description de la figure 7

Cette figure contient quatre sous-figures, chacune correspondant à une architecture différente (p. ex. ResNet-18). Chaque sous-figure montre la précision et la perte par rapport par rapport au numéro de la période (pour les phases d’entraînement et de validation) pour les modèles entraînés à classes multiples (version 2). | Numéro de l’époque | ResNet18 | ResNet34 | ResNet50 | VGG16 | ||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | précision à la phase d’entraînement | précision à la phase de validation | perte à la phase d’entraînement | perte à la phase de validation | |

| 0,475 | 0,638 | 1 466 | 1 074 | 0,492 | 0,636 | 1,440 | 1 058 | 0,491 | 0,645 | 1 433 | 1 049 | 0,555 | 0,659 | 1 277 | 1 023 | |

| 0,583 | 0,645 | 1 207 | 1 064 | 0,601 | 0,658 | 1 163 | 0,998 | 0,602 | 0,692 | 1 157 | 0,942 | 0,669 | 0,619 | 0,990 | 1 096 | |

| 0,626 | 0,668 | 1 072 | 1 008 | 0,649 | 0,697 | 1 012 | 0,943 | 0,654 | 0,686 | 1,010 | 0,946 | 0,709 | 0,678 | 0,864 | 0,949 | |

| 0,659 | 0,650 | 0,977 | 1 067 | 0,686 | 0,699 | 0,912 | 0,932 | 0,691 | 0,679 | 0,885 | 1 046 | 0,739 | 0,692 | 0,771 | 0,927 | |

| 0,693 | 0,680 | 0,881 | 1 004 | 0,720 | 0,696 | 0,805 | 0,974 | 0,724 | 0,669 | 0,791 | 1 093 | 0,771 | 0,708 | 0,692 | 0,888 | |

| 0,763 | 0,695 | 0,674 | 0,947 | 0,794 | 0,721 | 0,585 | 0,904 | 0,803 | 0,720 | 0,553 | 0,913 | 0,842 | 0,734 | 0,481 | 0,878 | |

| 0,791 | 0,702 | 0,600 | 0,960 | 0,817 | 0,723 | 0,514 | 0,936 | 0,830 | 0,724 | 0,474 | 0,925 | 0,859 | 0,731 | 0,437 | 0,898 | |

| 0,795 | 0,699 | 0,576 | 0,959 | 0,829 | 0,720 | 0,471 | 0,946 | 0,845 | 0,719 | 0,428 | 0,957 | 0,867 | 0,737 | 0,404 | 0,902 | |

| 0,808 | 0,705 | 0,548 | 0,973 | 0,842 | 0,722 | 0,437 | 0,978 | 0,859 | 0,715 | 0,388 | 0,978 | 0,878 | 0,735 | 0,374 | 0,930 | |

| 0,811 | 0,701 | 0,520 | 0,993 | 0,848 | 0,719 | 0,409 | 0,987 | 0,869 | 0,723 | 0,357 | 1 005 | 0,888 | 0,738 | 0,346 | 0,951 | |

| 0,828 | 0,705 | 0,489 | 0,984 | 0,862 | 0,719 | 0,367 | 0,996 | 0,879 | 0,723 | 0,324 | 1 002 | 0,900 | 0,739 | 0,311 | 0,957 | |

| 0,827 | 0,704 | 0,488 | 0,986 | 0,866 | 0,725 | 0,367 | 0,984 | 0,877 | 0,724 | 0,325 | 0,993 | 0,903 | 0,739 | 0,307 | 0,969 | |

| 0,826 | 0,703 | 0,483 | 0,991 | 0,866 | 0,723 | 0,365 | 1 001 | 0,881 | 0,724 | 0,318 | 1 006 | 0,901 | 0,739 | 0,305 | 0,974 | |

| 0,826 | 0,707 | 0,479 | 0,983 | 0,869 | 0,727 | 0,364 | 0,984 | 0,880 | 0,724 | 0,315 | 1 007 | 0,905 | 0,739 | 0,298 | 0,980 | |

| 0,826 | 0,701 | 0,485 | 0,998 | 0,870 | 0,725 | 0,358 | 0,996 | 0,880 | 0,726 | 0,312 | 1 016 | 0,905 | 0,740 | 0,293 | 0,987 | |

| Architecture | Précision à la phase d’entraînement | Précision à la phase de validation |

|---|---|---|

| ResNet18 | 0,83 | 0,71 |

| ResNet34 | 0,87 | 0,73 |

| ResNet50 | 0,88 | 0,73 |

| VGG16 | 0,91 | 0,74 |

Version 3

Une troisième version du modèle a été entraînée. Deux modifications ont été apportées au troisième modèle. Premièrement, l’ensemble de données a été examiné manuellement pour corriger les erreurs d’étiquetage des données. Les images de chaque classe ont été examinées afin de supprimer les images qui s’y trouvaient par erreur. La plupart des travaux de nettoyage concernaient les classes des garages et des toitures. Les données de la classe des garages contenaient de nombreuses images de maisons dont beaucoup n’avaient même pas de garage attenant. Les données dans cette classe ont été nettoyées pour contenir des images de garages ou du moins de maisons où un garage était apparent. En ce qui concerne la classe des toitures, l’ensemble de données est censé contenir les structures de toitures, comme celles des stations-service ou sur les façades d’hôtels. Toutefois, l’ensemble de données pour cette classe contenait d’autres images (maisons, immeubles d’appartements, etc.). En plus d’améliorer l’étiquetage des ensembles d’images, la probabilité d’exclusion pour ResNet50 et VGG15 a été réglée à 0,25.

Pour cette version, nous ne montrons que les valeurs les plus élevées obtenues pour la précision aux phases d’entraînement et de validation (tableau 4). D’après le tableau, on constate que la meilleure précision à la phase d’entraînement a été obtenue par l’architecture VGG16, qui a atteint une précision de 0,92. La précision à la phase d’entraînement pour les autres RNC variait entre 0,80 et 0,88. En raison de la valeur plus élevée de la probabilité d’exclusion utilisée pour l’architecture ResNet50, la plus grande précision à la phase d’entraînement est inférieure à celle obtenue par les architectures ResNet18 et ResNet34.

La meilleure précision à la phase de validation (0,78) a également été obtenue par l’architecture VGG16, les autres RNC ayant obtenu des valeurs de précision à la phase de validation allant de 0,75 à 0,77. Cela signifie que l’on obtient jusqu’à 11,4 % d’augmentation par rapport à la première version. Comme on peut le constater, une amélioration considérable découle du nettoyage de l’ensemble de données. Cela s’explique par le fait que le nettoyage élimine les images de l’ensemble de données d’entraînement ou de validation qui sont placées par erreur dans la mauvaise classe — ces images confondent le modèle entraîné et en réduisent la précision.

| Architecture | Précision à la phase d’entraînement | Précision à la phase de validation |

|---|---|---|

| ResNet18 | 0,85 | 0,75 |

| ResNet34 | 0,88 | 0,76 |

| ResNet50 | 0,80 | 0,77 |

| VGG16 | 0,92 | 0,78 |

La figure 8 montre les matrices de confusion obtenues à partir de l’ensemble de données de validation de la troisième version des RNC peaufinés. Comme on peut le voir, la meilleure précision à la phase de classification a été obtenue pour les classes des maisons, des garages et des toitures. Cela s’explique par le fait que ces classes présentent des caractéristiques distinctives. Cela montre également la contribution importante de la correction manuelle de l’étiquetage pour aider le modèle à faire la distinction entre la classe des maisons et la classe des garages. Les pires résultats de classification ont été obtenus pour les classes des commerces de détail et des immeubles de bureaux. Les commerces de détail ont des caractéristiques communes avec d’autres classes. Par exemple, elles peuvent être confondues avec la classe des constructions industrielles (les bâtiments industriels peuvent avoir des affiches), la classe des toitures (on retrouve surtout des toitures sur les stations-service avec des dépanneurs) et la classe des appartements (il peut y avoir des magasins au rez-de-chaussée). Certains immeubles de bureaux peuvent ressembler à des immeubles d’appartements ou avoir des magasins au rez-de-chaussée, ce qui peut faire en sorte qu’ils soient classés dans les catégories susmentionnées.

Comme il a été mentionné précédemment, l’ensemble de données de référence contient un ensemble de données de test. L’ensemble de données de test comprend 2 000 images recueillies dans des villes autres que celles qui font partie de l’ensemble de données d’entraînement. La version 3 du modèle VGG16 a été exécutée à partir de l’ensemble de données de test, car ce modèle a fourni la meilleure précision à la phase de validation. La précision à la phase de classification obtenue avec l’architecture VGG16 (version 3) à partir de cet ensemble était de 0,69. Il s’agit d’une amélioration importante (17 %) de la précision par rapport à celle obtenue par la version 1 et à celle obtenue par (Kang et coll., 2018).

Malgré les résultats positifs obtenus, il est possible de faire mieux. En analysant et en optimisant les classes et l’ensemble de données d’entraînement, l’étiquetage de l’ensemble de données d’entraînement pourrait être encore amélioré et permettre une classification plus précise.

Description de la figure 8

Cette figure illustre les matrices de confusion obtenues sur l’ensemble de validation avec les réseaux neuronaux convolutifs affinés (modèle à classes multiples – version 3) pour : a) ResNet-18, b) ResNet-34, c) ResNet-50, et d) VGG-16. | immeuble d’appartements | église | garage | maison | construction industrielle | immeuble de bureaux | commerce de détail | toiture | ||

|---|---|---|---|---|---|---|---|---|---|

| Image réelle (Resnet18) | prédiction (ResNet18) | ||||||||

| immeuble d’appartements | 0,76 | 0,04 | 0,01 | 0,06 | 0,03 | 0,06 | 0,03 | 0,01 | |

| église | 0,07 | 0,77 | 0,01 | 0,05 | 0,02 | 0,03 | 0,06 | 0 | |

| garage | 0,02 | 0,04 | 0,79 | 0,11 | 0,02 | 0,02 | 0,01 | 0 | |

| maison | 0,04 | 0,04 | 0,03 | 0,83 | 0,03 | 0,01 | 0,02 | 0 | |

| construction industrielle | 0,04 | 0,03 | 0,02 | 0,02 | 0,74 | 0,04 | 0,10 | 0,01 | |

| immeuble de bureaux | 0,10 | 0,05 | 0 | 0,05 | 0,06 | 0,64 | 0,08 | 0,01 | |

| commerce de détail | 0,04 | 0,03 | 0 | 0,06 | 0,08 | 0,05 | 0,68 | 0,06 | |

| toiture | 0,03 | 0,02 | 0,01 | 0,01 | 0,01 | 0,01 | 0,09 | 0,82 | |

| Image réelle (Resnet34) | prédiction (Resnet34) | ||||||||

| immeuble d’appartements | 0,77 | 0,04 | 0,02 | 0,10 | 0,02 | 0,03 | 0 | 0,01 | |

| église | 0,05 | 0,77 | 0,01 | 0,80 | 0,01 | 0,03 | 0,02 | 0,01 | |

| garage | 0,02 | 0,02 | 0,86 | 0,09 | 0 | 0 | 0 | 0 | |

| maison | 0,07 | 0,04 | 0,04 | 0,82 | 0,02 | 0,01 | 0,01 | 0 | |

| construction industrielle | 0,04 | 0,04 | 0,01 | 0,02 | 0,74 | 0,03 | 0,09 | 0,03 | |

| immeuble de bureaux | 0,10 | 0,03 | 0,01 | 0,05 | 0,02 | 0,69 | 0,09 | 0,02 | |

| commerce de détail | 0,05 | 0,05 | 0,01 | 0,06 | 0,06 | 0,06 | 0,65 | 0,07 | |

| toiture | 0,03 | 0,01 | 0 | 0,01 | 0,01 | 0,02 | 0,05 | 0,86 | |

| Image réelle (Resnet50) | prédiction (Resnet50) | ||||||||

| immeuble d’appartements | 0,76 | 0,04 | 0,01 | 0,04 | 0,02 | 0,09 | 0,02 | 0,01 | |

| église | 0,07 | 0,77 | 0,01 | 0,04 | 0,03 | 0,04 | 0,03 | 0,01 | |

| garage | 0,01 | 0,01 | 0,83 | 0,08 | 0,02 | 0,03 | 0,02 | 0,01 | |

| maison | 0,06 | 0,03 | 0,03 | 0,82 | 0,02 | 0,01 | 0,01 | 0,01 | |

| construction industrielle | 0,02 | 0,03 | 0,01 | 0,02 | 0,77 | 0,04 | 0,09 | 0,02 | |

| immeuble de bureaux | 0,07 | 0,02 | 0 | 0,02 | 0,04 | 0,76 | 0,07 | 0,02 | |

| commerce de détail | 0,02 | 0,02 | 0 | 0,03 | 0,11 | 0,07 | 0,67 | 0,08 | |

| toiture | 0,01 | 0 | 0 | 0,01 | 0,01 | 0,01 | 0,12 | 0,83 | |

| Image réelle (VGG16) | prédiction (VGG16) | ||||||||

| immeuble d’appartements | 0,76 | 0,03 | 0,01 | 0,07 | 0,02 | 0,07 | 0,04 | 0,01 | |

| église | 0,06 | 0,78 | 0,01 | 0,04 | 0,04 | 0,02 | 0,05 | 0 | |

| garage | 0 | 0 | 0,86 | 0,10 | 0,01 | 0 | 0,03 | 0 | |

| maison | 0,03 | 0,04 | 0,03 | 0,87 | 0,02 | 0 | 0,01 | 0 | |

| construction industrielle | 0,02 | 0,04 | 0 | 0,02 | 0,78 | 0,04 | 0,10 | 0 | |

| immeuble de bureaux | 0,08 | 0,04 | 0,01 | 0,03 | 0,05 | 0,69 | 0,08 | 0,01 | |

| commerce de détail | 0,03 | 0,03 | 0,01 | 0,04 | 0,12 | 0,03 | 0,67 | 0,06 | |

| toiture | 0 | 0,01 | 0 | 0,02 | 0,02 | 0,01 | 0,06 | 0,86 | |

|

Source : |

|||||||||

5 Conclusion et travaux futurs

Dans la présente recherche, les réseaux neuronaux convolutifs (RNC) ont été peaufinés pour classer les bâtiments en fonction de leurs différents types (p. ex. maisons, immeubles d’appartements, bâtiments industriels) au moyen de leurs images prises à partir de la rue. Les RNC utilisent la structure de la façade dans l’image du bâtiment afin de le classer. Plusieurs RNC de pointe (p. ex. ResNet50 et VGG16) ont été peaufinés pour classer les bâtiments au moyen de leurs images prises à partir de la rue. Le rendement obtenu aux phases d’entraînement et de validation de chaque RNC entraîné a été mesuré et est énoncé dans le présent document. Au total, trois versions d’un modèle à classes multiples ont été entraînées et présentées. Dans la première version, les RNC ont été peaufinés selon un ensemble de données d’entraînement et évalués selon un ensemble de validation distinct d’images prises à partir de la rue. Une précision de validation allant jusqu’à 0,7 (ou 70 %) a été obtenue avec la première version du modèle. Une deuxième version du modèle à classes multiples a été entraînée avec tous les réseaux sur le même ensemble de données, mais avec un réglage supplémentaire des hyperparamètres et une approche différente de l’augmentation des données. Une précision de validation de 0,74 ou 74 % (c.-à-d. une amélioration de 5,7 % par rapport à la première version) a été obtenue avec la deuxième version du modèle. En outre, une troisième version du modèle a été entraînée avec les mêmes paramètres que la deuxième version, mais au moyen d’un ensemble de données qui a été examiné manuellement pour corriger les erreurs d’étiquetage des images. La troisième version du modèle a connu encore plus de succès : sa précision de validation est allée jusqu’à 0,78 ou 78 % (soit une amélioration de 11,4 % par rapport à la première version). Outre ce qui précède, les modèles ont été évalués selon un ensemble d’essai d’images prises dans des villes différentes de celles de l’ensemble de données d’entraînement. Les résultats montrent que les RNC peuvent être utilisés pour classer les bâtiments au moyen de leurs images prises à partir de la rue avec une précision de classification allant jusqu’à 0,78 (ou 78 %) au moyen d’images d’essai de bâtiments des mêmes villes dans l’ensemble de données d’entraînement et avec une précision allant jusqu’à 0,69 (ou 69 %) au moyen d’images d’essai de villes différentes. Les résultats obtenus avec la troisième version du modèle au moyen de l’ensemble d’essai provenant de différentes villes ont montré une augmentation de 17 % de la précision de classification par rapport à celle obtenue avec la première version.

Malgré les résultats positifs, il est possible de faire mieux pour améliorer la précision de la classification des modèles. D’autres travaux pourraient être mis en œuvre pour améliorer et restructurer les ensembles de données, et combiner certaines catégories similaires comme les maisons et les garages afin d’accroître la précision des modèles. L’apprentissage par transfert pourrait également être mis en œuvre pour peaufiner et mettre à l’essai les modèles au moyen d’images qui, dans la présente application, ont été prises exclusivement dans une ville du Canada. De plus, les RNC pourraient être peaufinés pour produire différents modèles de classification pouvant être utilisés afin d’extraire plus de caractéristiques des bâtiments d’intérêt (p. ex. maison jumelée, maison en rangée). Aussi, un système automatique pourrait être élaboré pour la mise en commun de l’acquisition et de la classification d’images avec les modèles entraînés. En particulier, l’RNC Google Street View Static a des limites et des modalités d’utilisation. Par conséquent, tout modèle dépassant le niveau de la validation de principe pourrait nécessiter un entraînement avec des images obtenues à partir d’une variété de sources différentes.

Références

Al-Habashna, A. (2020). Un système à code source ouvert pour l’estimation de la hauteur des bâtiments au moyen d'images prises à partir de la rue, de l'apprentissage profond et d'empreintes d'immeubles. Statistique Canada Articles et rapports: 18-001-X2020002. https://www150.statcan.gc.ca/n1/pub/18-001-x/18-001-x2020002-fra.htm

Al-Habashna, A. (2021). Building Height Estimation using Street-View Images, Deep-Learning, Contour Processing, and Geospatial Data. Proceedings - 2021 18th Conference on Robots and Vision, CRV 2021, 103–110.

Dong, S., Wang, P., et Abbas, K. (2021). A survey on deep learning and its applications. Computer Science Review, 40, 100379.

Gebru, T., Krause, J., Wang, Y., Chen, D., Deng, J., Aiden, E. L., et Fei-Fei, L. (2017). Using deep learning and google street view to estimate the demographic makeup of neighborhoods across the United States. Proceedings of the National Academy of Sciences of the United States of America, 114(50), 13108–13113.

Giri, C. (2016). Remote Sensing of Land Use and Land Cover. In Remote Sensing of Land Use and Land Cover. CRC Press. Récupéré de https://www.taylorfrancis.com/https://www.taylorfrancis.com/books/mono/10.1201/b11964/remote-sensing-land-use-land-cover-chandra-giri.

Google. (2020). Street View Static RNC. Récupéré de https://developers.google.com/maps/documentation/streetview/intro.

Grab Holdings. (2009). Open Street Cam. Récupéré de https://openstreetcam.org/map/@45.37744755572422,-75.65142697038783,18z.

He, K., Zhang, X., Ren, S., et Sun, J. (2016). Deep residual learning for image recognition. Proceedings of the IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2016-December, 770–778.

Kang, J., Körner, M., Wang, Y., Taubenböck, H., et Zhu, X. X. (2018). Building instance classification using street view images. ISPRS Journal of Photogrammetry and Remote Sensing, 145, 44–59.

Li, X., Zhang, C., et Li, W. (2017). Building block level urban land-use information retrieval based on Google Street View images. GIScience and Remote Sensing, 54(6), 819–835. https://www.tandfonline.com/doi/abs/10.1080/15481603.2017.1338389.

Mapillary. (2014). Mapillary. Récupéré de https://www.mapillary.com/.

OpenStreetMap. (2004). OpenStreetMap. Récupéré de https://www.openstreetmap.org/#map=4/30.56/-64.16.

PyTorch. (2016). PyTorch. Récupéré de https://pytorch.org/.

Quinn, J. et coll. (2019). Dive Into Deep Learning: Tools for Engagement Paperback (1st ed.). Corwin.

Russakovsky, O., Deng, J., Su, H., Krause, J., Satheesh, S., Ma, S., Huang, Z., Karpathy, A., Khosla, A., Bernstein, M., Berg, A. C., et Fei-Fei, L. (2015). ImageNet Large Scale Visual Recognition Challenge. International Journal of Computer Vision, 115(3), 211–252. http://image-net.org/challenges/LSVRC/.

Simonyan, K., et Zisserman, A. (2015, September 4). Very deep convolutional networks for large-scale image recognition. 3rd International Conference on Learning Representations, ICLR 2015 - Conference Track Proceedings. Récupéré de http://www.robots.ox.ac.uk/.

Voulodimos, A., Doulamis, N., Doulamis, A., et Protopapadakis, E. (2018). Deep Learning for Computer Vision: A Brief Review. In Computational Intelligence and Neuroscience (Vol. 2018). Hindawi Limited.

- Date de modification :